Sora 我想了很久该怎么讲,也问了一些人,但其实技术层面的解读已经很多了,产品上也没有开放,再去赘述也没什么意思,本质上 Sora 还是模型能力的一种延续,所以在这期里,我们把 Sora、英伟达 等统一到了一个大的叙事逻辑之下来讨论。

我们讲了 Sora 的意义和影响是什么,英伟达持续飙涨的背后原因是什么 (以及是否可持续?),还讨论了 AI 世界 (尤其是海外) 到底在发生什么,以及在这个叙事下不同阶段的逻辑、可能产生的变化是什么。相信听完这期播客,大家都能从宏观上对整体的 AI 发展有一个把握,再去看各种新模型、新热点也都能有更好的对号入座的理解。

如播客中所讲,我们目前其实是处于 1.0 时代到 1.5 时代的交替过程中,我们也十分期盼 2.0 时代 AI 真正爆发的到来。

【人类博物馆】

导游:曲凯,42章经创始人

九号珍藏:莫傑麟,家族办公室资深从业者

【时光机】

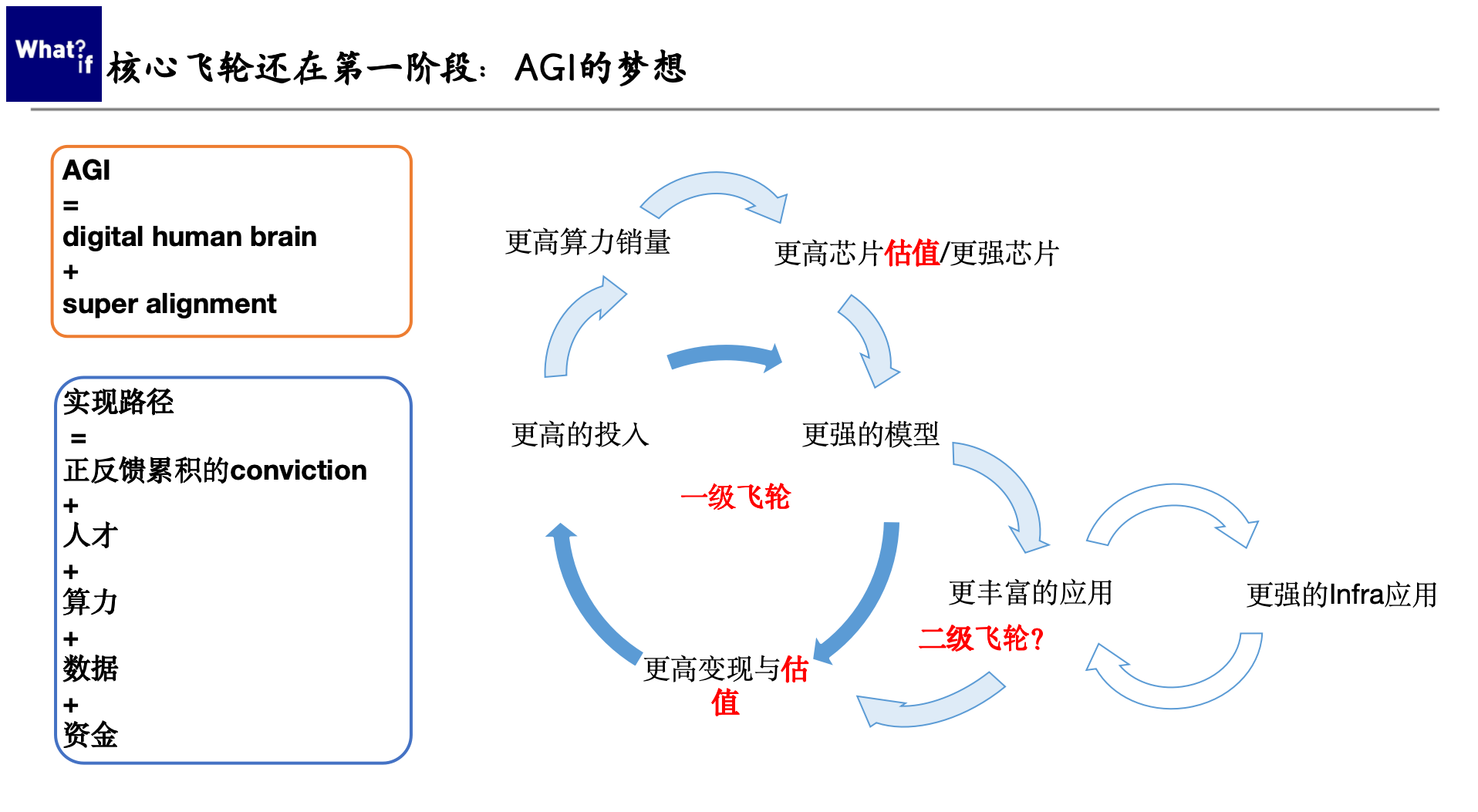

- 1:33 如何理解 AI 市场的核心逻辑?

- 1:42 AI 1.0 阶段的叙事逻辑:Scaling law

- 4:41 AI 1.5 阶段的叙事逻辑:Scale in & Scale out

- 5:56 AI 2.0 阶段的叙事逻辑:应用的大爆发

- 9:28 AI 应用目前处于一个试探玩法的阶段

- 11:10 国内这波创始人的质量是相当高的

- 12:51 AI 投资的三种表现

- 19:16 评估英伟达的股价,要同时具备微观、中观、宏观三种视角

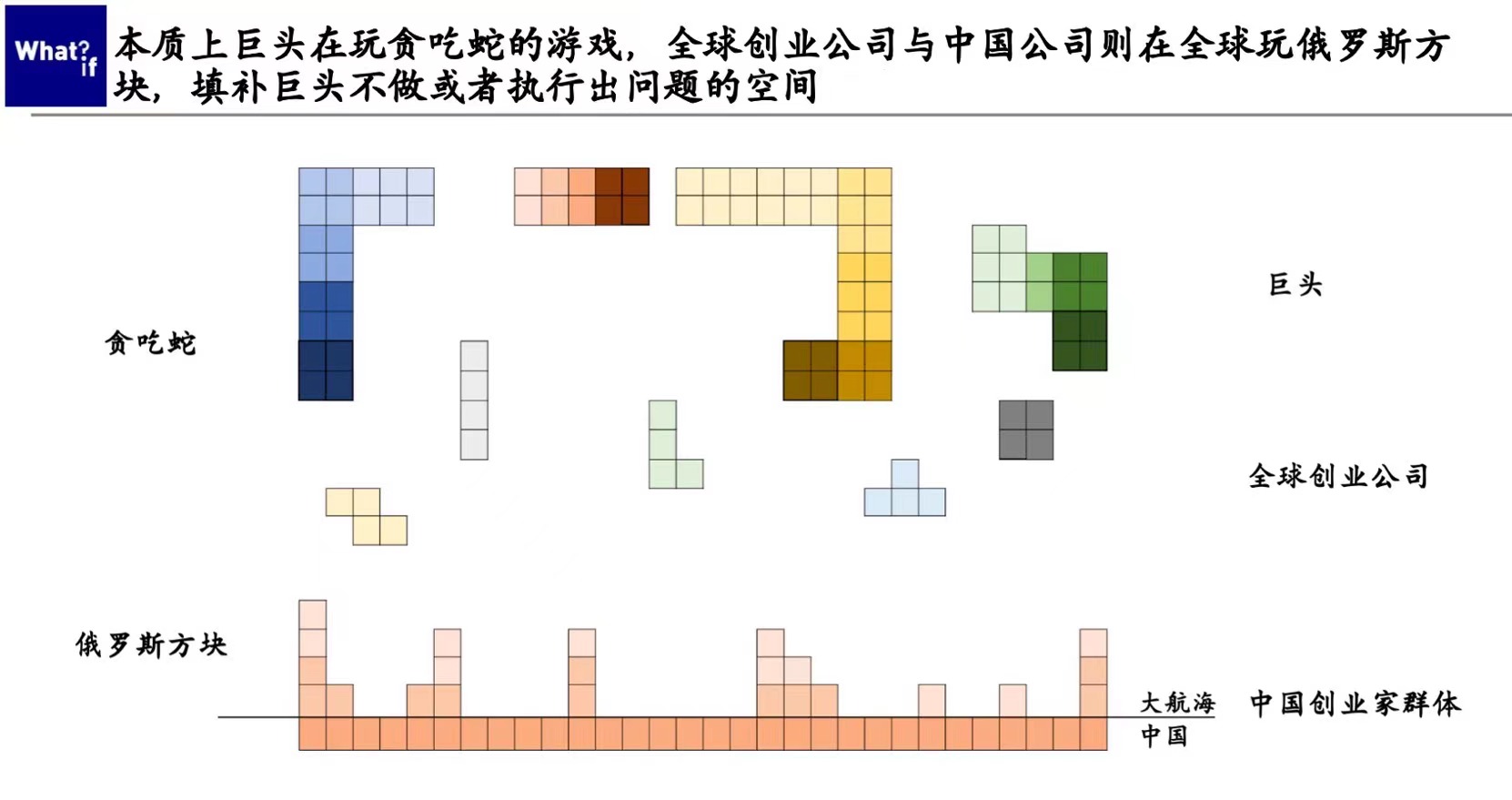

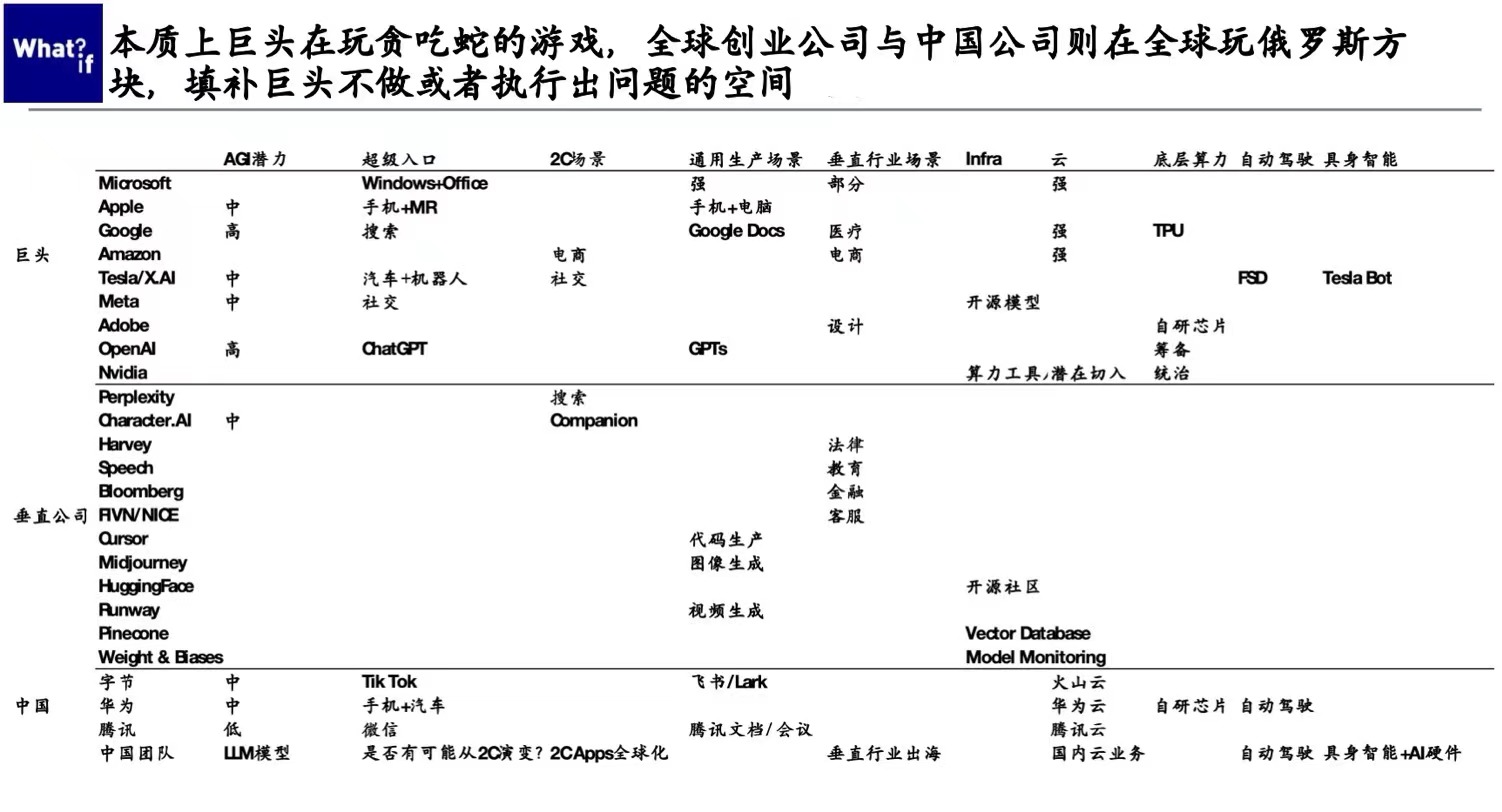

- 21:20 贪吃蛇与俄罗斯方块的游戏

- 22:23 大公司与创业公司的博弈像一场「球球大作战」的游戏

- 29:57 国内大模型和 OpenAI 之间的差距到底是在缩进还是在拉远?

- 31:31 关于 Sora 的几点启发

- 33:12 Sam Altman 是面壁人,Elon Musk 是破壁人,Jensen Huang 是真正的受益人

- 35:24 行业开始洗牌,谁领先,谁出局,会是今年的核心看点

【The gang that made this happen】

- 制作人:Celia

- 剪辑:思娜

- 片头 bgm:Mondo Bongo - Joe Strummer & The Mescaleros

【Reference】

为什么我们开始乐观?关于经济发展的明线暗线、AI 与最佳实践 | 对谈莫傑麟

最后,我们的 AI 私董会也在持续报名中,目前已经聚集了一批市场上最好的 AI 创始人,欢迎点击链接报名(里面也有目前已加入的成员名单,可点击查看)

32377

32377 77

77

正好我是在云计算行业,我解释下什么是scale in(这是第一次在自媒体听到这么专业的词);这是云计算的terms,scale in指压缩能力强,scale out指压缩能力弱,比如Sora和现在llm算法一个核心的算法能力是压缩能力,没有压缩能力的算法实质上会被scaling law淘汰,因为今天的算法不只是考虑软件,而是要考虑硬件和存储,实际上scaling law这个阶段大部分是来自于transformer和硬件,存储问题很难解决,sora的惊艳表现很大程度上复用transformer得到了加速和压缩能力

再一次说:很专业和准确