今天的嘉宾是谢青池,他是美团光年之外的产品负责人。

一个月前,青池找到我,说他用了一年多的时间一篇一篇地啃完了200多篇AI论文,从开始全然不得要领,到后来逐渐地入门——而他希望将他的论文探索之旅开源给大家。

就这样,我们有了今天这集特别的节目。

他从200多篇论文中精选了36篇经典,4小时讲解,带你穿越AI变迁史。

他说,读论文是“给你打开一扇门”,让你能直接“与这个世界最聪明的头脑对话”。

2025年,期待我们和AI共同进步!

01:30 探索的缘起

07:25 怎么读论文?(用AI学AI)

10:20 辅助小工具和路书

论文讲解的主干:

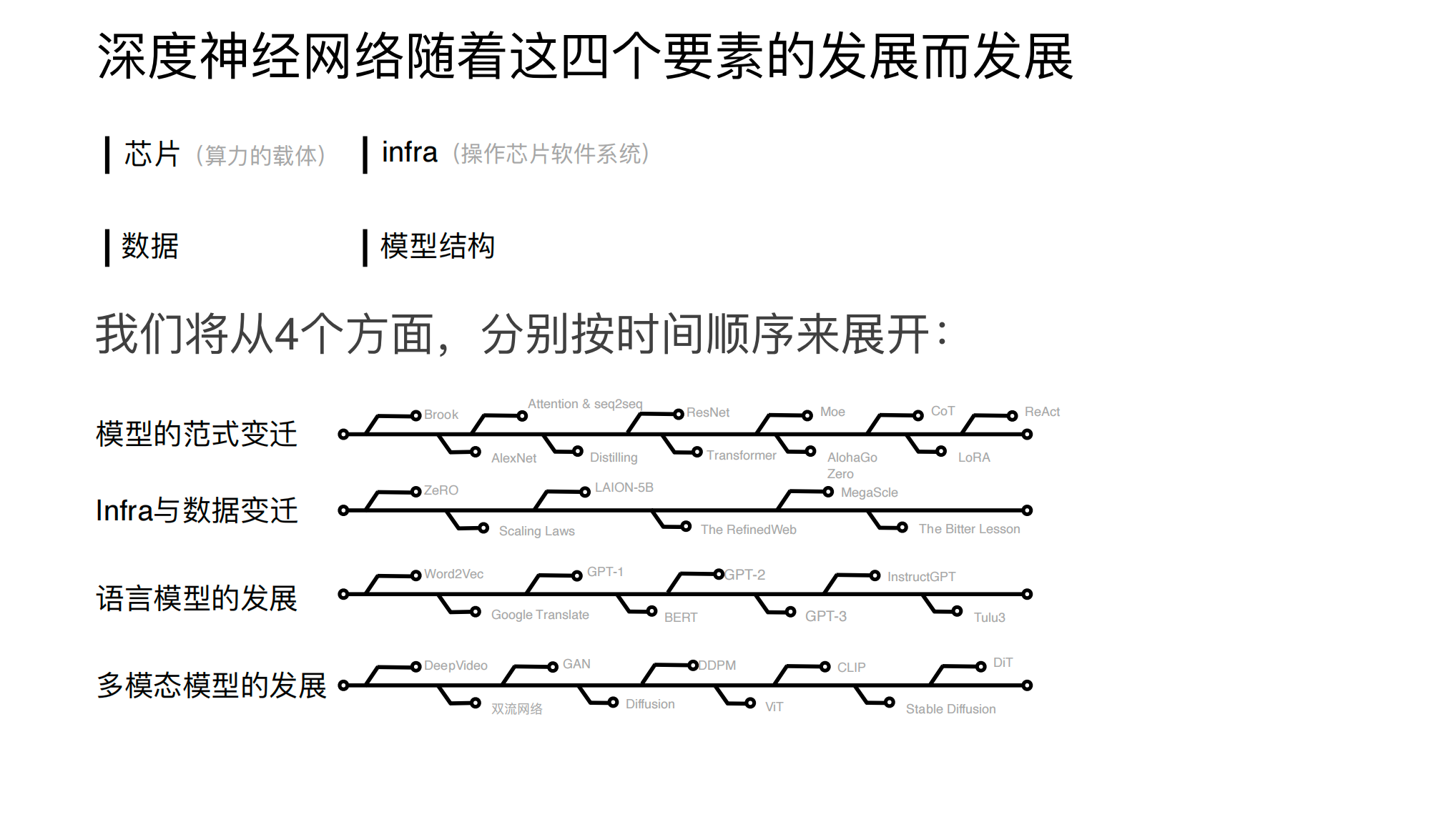

19:35 Part 1:模型的范式变迁

故事要从1999年的第一颗GPU开始讲起

Brook: 用GPU进行计算 (2004.08)

AlexNet: 深度学习的开端(2012.10)

对序列建模:seq2seq和Attention的引入(2014.09)

蒸馏:模型能被学习吗?(2015.03)

ResNet: 比深更深(2015.12)

Transformer来了!拉开一个时代的序幕(2017.06)

AlphaGo Zero: 强化学习的突破(2017.10)

现代MoE的开端(2017.01)

CoT: Prompt Engineering的奠基之作(2022.01)

LoRA: 那个我们每天都在用的东西(2021.06)

ReAct: Agent从理论到落地(2022.10)

The Bitter Lesson: 过去70年的教训(2018.08)

01:52:58 Part 2:Infra与数据的变迁

ZeRO: 大规模的GPU并行计算(2019.10)

Scaling Law & Chinchilla: 上帝的指挥棒(2020.01 2022.03)

LAION-5B: 开源社区的英雄主义(2022.10)

The RefinedWeb: 互联网的数据也很够用(2023.06)

MegaScale: 万卡GPU集群的训练(2024.02)

02:21:29 Part 3:语言模型的发展

Word2Vec: 用机器学习将单词向量化(2013.01)

Google Translate: 神经网络的大规模线上部署(2016.09)

GPT-1,它来了(2018.06)

BERT: 曾经的王(2018.10)

GPT-2: 是时候告别微调了(2019.02)

GPT-3: ChatGPT来临前夜(2020.05)

InstructGPT: 给LLM以文明(2022.03)

Tulu 3: 后训练的开源(2024.11)

03:08:08 Part 4:多模态模型的发展

DeepVideo: 深度学习进入视频领域,Andrej 初出茅庐(2014.06)

双流网络: Karén和学术重镇牛津登场(2014.06)

图像生成的序章: GAN来了(2014.06)

Diffusion: 在GAN的阴影下,悄然成长(2015.03)

DDPM: Diffusion重回图像舞台的中央(2020.06)

ViT: 当图像遇到Transformer(2020.10)

CLIP: 文生图的奠基石(2021.03)

Stable Diffusion,它来了(2021.12)

DiT: 人们期待一个融合的未来(2022.12)

03:56:38 最后的聊天

架构抱住了硬件的大腿

今天技术的边界到达了哪?

给“站在AI世界门外张望的人”和“已经在体系中工作多年的人”的建议

【技术之美】系列:

逐句讲解DeepSeek-R1、Kimi K1.5、OpenAI o1技术报告——“最优美的算法最干净”

逐篇讲解DeepSeek关键9篇论文及创新点——“勇敢者的游戏”

逐篇讲解DeepSeek、Kimi、MiniMax注意力机制新论文——“硬件上的暴力美学”

逐篇讲解机器人基座模型和VLA经典论文——“人就是最智能的VLA”

逐段讲解Kimi K2报告并对照ChatGPT Agent、Qwen3-Coder等:“系统工程的力量”

【更多信息】

本集的投屏视频版已经同步发布于Bilibili(张小珺商业访谈录):www.bilibili.com

50页完整PPT开源地址(所有论文链接附在PPT上):w7py8ou4dk.feishu.cn

42632

42632 129

129

1. 吴文达-机器学习和AI

2. 李宏毅-生成式AI时代下的机器学习(2025版本)b站有

3. 油管:Andrej Karpathy

4. b站up主-李沐:论文精读系列

5. b站up主-3 blue 1 brown:可视化科普视频

6. b站up主-zomi酱:AI infra

7. b站up主-王木头学科学

书:

1. 一站式LLM底层技术原理入门指南(飞书文档)

2. 动手学深度学习(开源,李沐有配套的讲解视频)

3. 深度学习中的数学(简单介绍概率论)