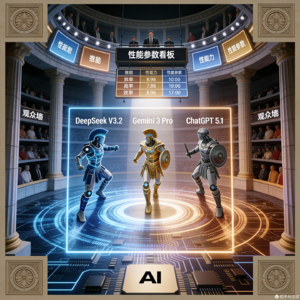

本期播客主要围绕 DeepSeek 发布的 V3.2 和 V3.2-Speciale 大型语言模型,这些模型已根据 MIT 许可证开源,旨在直接挑战如 GPT-5 和 Gemini 3 Pro 等专有系统。这种竞争力的核心在于其高效的架构,它结合了拥有 6710 亿总参数的稀疏专家混合 (MoE) 设计和创新的 DeepSeek Sparse Attention (DSA) 机制。DSA 能够显著提高长文本处理的效率,使其能够经济高效地处理长达 128K token 的上下文,该效率已在早期的 DeepSeek-V3.2-Exp 实验版本中得到验证。在不牺牲性能的前提下,这些模型在 数学和编程基准测试等专业技术领域取得了与领先闭源模型相当或更高的成绩。得益于这些技术突破,DeepSeek 提供了比主要竞争对手低 10 至 25 倍的 API 定价,从而极大地扰乱了前沿 AI 服务的市场经济结构。开发者可以选择兼顾成本的 V3.2 标准版或针对极致推理任务而优化的 V3.2-Speciale 变体。

DeepSeek V3.2何以能挑战Gemini 3 Pro和ChatGPT 5.1?

18分钟 · 1·

1· 0

0

1

1 0

0